14 Jan Améliorez votre référencement en désindexant votre contenu inutile

Et quel est l’objectif d’un moteur de recherche ?

Explorer votre site afin de proposer le meilleur contenu à ses utilisateurs ! Alors, si vous lui mâchez le travail, en lui indiquant clairement le contenu que vous jugez utile pour les internautes et celui qui ne l’est pas, il vous en sera reconnaissant !

Alors comment faire ?

Il y a plusieurs méthodes :

– le robots.txt : une méthode radicale mais qui fera appel à votre côté geek !

– la balise « noindex » : une méthode nettement plus simple mais un peu un moins radicale…

1. Le fichier Robots.txt : Définition et mode d’emploi

Qu’est ce qu’un fichier robots.txt et à quoi sert-il ?

Le fichier robots.txt ne vous dira sans doute rien si vous êtes débutant en webmarketing. Pourtant, ce fichier a 2 graaandes utilités pour votre site !

– La fonction première d’un fichier robots.txt est d’indiquer aux robots des moteurs de recherche (d’où son nom !) ce qu’ils doivent et ce qu’ils ne doivent pas indexer dans votre site.

Les robots des moteurs de recherche sont ces petits robots qui vont explorer votre site, pour ensuite pouvoir le présenter dans leurs pages de résultats. Ces robots consulteront donc votre fichier robots.txt avant d’indexer votre site. Et vous êtes en mesure de leur dire : « Je veux que telle page appraisse dans les moteurs de recherche et telle autre non ! ».

– Deuxièmement, il améliorera votre référencement dans les pages de résultats de Google, et des moteurs de recherche en général, en facilitant son travail d’exploration !

Comment savoir si vous avez déjà un fichier robots.txt et comment le visualiser ?

Bonne nouvelle ! Normalement, vous n’avez rien à faire pour le mettre en place, il est généré automatiquement à la création de votre site (pour info, il est situé à la racine de votre serveur).

Pour être certain de son existence et le visualiser, vous pouvez vous rendre sur la page d’accueil de votre site, puis tapez : /robots.txt à la fin de l’adresse (URL) de votre site et affichez la page. Par exemple, dans notre cas, ce serait : www.beinweb.fr/robots.txt

NB : Si vous ne le trouvez pas, vous pourrez toujours créer votre fichier robots.txt, à l’aide de votre meilleur ami en termes de référencement : Google Webmaster Tools.

> Regardez notre petit tuto ici.

Dans votre compte, allez dans l’onglet « Exploration » puis « outil de test du fichier robots.txt ».

ASTUCE : Toujours sur cette même page (dans la zone du bas), vous pourrez tester les urls de votre site pour savoir si elles sont bien indexées par Google, dans le cas où vous ne les trouvez pas sur les pages de résultats !

Comment se présente votre fichier robots.txt ?

Par défaut, le fichier robots.txt contient ces 3 informations :

– User-agent : cette ligne indique quel robot (quel moteur de recherche) est concerné.

Le caractère * signifie que cela concerne tous les robots.

– Allow : cette ligne signifie « autorisation ».

Le caractère / signifie que l’on peut accéder à toutes les URLs de votre site.

Vous avez compris, si vous souhaitez que tout le contenu de votre site soit indexé dans les moteurs de recherche, modifier le fichier robots.txt est inutile ! Si vous laissez votre fichier tel quel, vous indiquerez aux robots des moteurs de recherche que vous souhaitez que tout votre contenu soit systématiquement indexé.

Mais vous pourriez avoir besoin d’exclure une URL de votre site (ou un répertoire entier) de l’indexation. Dans ce cas, vous aurez une nouvelle ligne « Disallow » :

– Disallow : Cette ligne concerne donc le contenu que vous voulez exclure des moteurs de recherche !

NB : Pour exclure une url, renseignez le le chemin de la page depuis la racine du site, c’est à dire tout ce qui se trouve derrière l’extension (.com, .fr, etc). Pour l’adresse de cette page par exemple : https://beinweb.fr/comment-desindexer-des-pages-de-votre-site/, il faudrait donc renseigner :

Disallow: /comment-desindexer-du-contenu-sur-google

Si vous avez besoin d’exclure plusieurs URLs, ajoutez autant de lignes Disallow: que besoin !

Si vous souhaitez enfin que Google n’indexe pas un répertoire entier de votre site (par exemple, le répertoire wp-admin), il faudrait modifier le fichier comme ceci :

Disallow: /wp-admin

Tout cela vous semble un peu barbare ?

Un conseil : Ne le modifiez pas sans maîtriser le sujet. Ayez bien conscience qu’une erreur d’écriture pourrait avoir un effet non désiré sur votre référencement !

Nous allons donc voir comment indiquer à Google de ne pas indexer tel ou tel contenu, sans rentrer dans la technique !

2. Une alternative au fichier robots.txt : la balise « noindex »

Comme toujours, nous allons vous donner une solution plus simple, si vous avez un côté geek très peu développé ! :)

Pour donner l’ordre aux moteurs de recherche d’indexer certains de vos contenus et d’en ignorer d’autres, vous pouvez passer par LE plugin indispensable pour votre référencement : WordPress SEO. Nous vous avions dit que c’était le plugin qui faciliterait tout votre référencement !

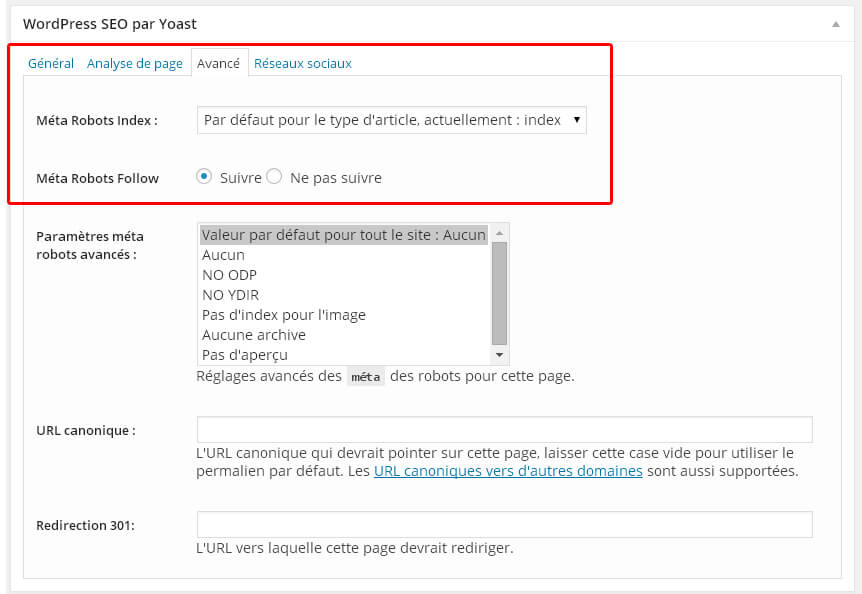

Une fois le plugin installé, en bas de chacune de vos pages, dans la rubrique « WordPress SEO par Yoast« , allez dans l’onglet « Avancé » (comme dans l’image ci-dessous) :

Dans la première ligne « Méta Robots Index », vous pouvez choisir l’option « noindex » du menu déroulant pour ne pas indexer cette page :

En activant cette option, vous allez insérer une balise (ou petite étiquette) « NoIndex » dans votre fichier robot.txt. Cette balise désactivera l’indexation de la page en question par les moteurs de recherche.

La différence entre cette pratique et le fichier robots.txt, c’est que la balise « NoIndex » ordonne au robot de suivre les URL sans en indexer le contenu, alors que la mention « Disallow » du fichier robots.txt ordonne au robot de complètement les ignorer. Vous l’aurez donc compris, passer par le fichier robots.txt est donc plus sûr en termes de résultats mais plus laborieux !

NB : Si vous n’avez pas installé le plugin WordPress SEO, vous pouvez également passer par Google Webmaster Tools.

Dans le menu de gauche « Index Google » puis dans l’onglet « urls à supprimer« , vous pouvez demander à Google d’arrêter d’indexer une page en question.

> Regardez notre petit tuto ici.

3. Quel contenu désindexer dans les moteurs de recherche ?

Posez-vous donc les questions suivantes : Il y a t il des pages de votre site dont vous aimeriez bloquer l’accès et qu’elles n’apparraissent pas dans Google ?

– Il y a t il des pages confidentielles ? Par exemple, la page d’un ebook gratuit à laquelle vous ne voulez pas que les internautes accèdent sans passer par l’inscription sur votre site.

– Il y a t il des pages en maintenance ? Par exemple, lors de la refonte d’un site, des pages qui ne sont pas finalisées et que vous ne voulez pas encore présenter dans les moteurs de recherche.

– Il y a t il des pages en double qui pourraient être considérées comme du « contenu dupliqué » et pénalisées par Google ? Dans ces cas là, choisissez quelle page de référence vous voulez indexer dans Google.

– Il y a t il des pages qui n’ont pas d’importance réelle pour vos utilisateurs ? Par exemple, la page de « mentions légales ». A la création de votre site, c’est souvent l’une des pages les plus rapidement indexées par Google. Or il serait dommage que votre internaute entre sur votre site par la « petite porte » non ? ;)

Vous avez donc compris, autant la balise « noindex » que le robots.txt sont un moyen de filtrer le contenu visible pour les internautes. Vous allez pouvoir définir les éléments que vous allez envoyer à Google et les éléments vous allez garder pour vous.

Allez, hop, au travail ! :)

Pingback:Tutoriel WordPress SEO: LE meilleur plugin WordPress !

Posté à 22:36h, 03 mai[…] Pour en savoir plus sur quelles pages de votre site vous devriez désindexer, lisez notre billet : Améliorez votre référencement en désindexant votre contenu inutile […]

Netshore

Posté à 15:18h, 24 juinbonjour,

en utilisant robots.txt, je veux bien bloquer l’accès à une catégorie mais pas ces sous-catégories, si je fait :

Agent: *

Disallow: /cat/

cela bloquera t il automatiquement l’accès à /cat/subcat1, /cat/subcat2/ etc.. ?

PS: j’utilise wordpress

Anaïs Villelongue

Posté à 07:26h, 26 juinOui ! Et je ne comprends pas bien l’intérêt de bloquer l’accès à une catégorie mais pas ses sous-catégories…

maguy

Posté à 21:49h, 10 décembrebonjour, votre article est tres interressant , je voudrais aussi empêcher google d’indexer certain contenu de mon blog. j’ai suivi le lien « petit tuto ici » mais je n’ai pas eu de tuto. pouvez vous m’aidez et me dire la marche à suivre svp?

WordPress seo est introuvable dans les extensions je me demande si ce n’est pas devenu yoast by seo. Merci

Anaïs Villelongue

Posté à 13:36h, 12 décembrebonjour Maguy,

merci pour votre message !

oui effectivement pour wordpress seo est devenu yoast by seo ;)

mauvaise nouvelle : il faut désormais avoir la version premium pour avoir accès aux paramètres avancés et désindexer manuellement vos pages…

Elodie

Posté à 07:46h, 31 janvierBonjour et merci pour cet article. Je constate avec consternation que google n’indexe pas les pages de mon blog. Je n’ai pourtant rien bloqué dans l’administration de mon site. Aurais-je une amélioration si je supprime la ligne Allow ?

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Anaïs Villelongue

Posté à 12:56h, 31 janvierBonjour Elodie,

Qu’est ce qui vous fait dire que Google n’indexe pas votre site ? Ou peut etre il seulement mal référencé ? Quelle est l’url de votre blog, je vais faire le test de mon coté…

Non votre fichier robots.txt tel qu’il est n’empeche pas Google de passer sur votre site en tous cas !

Youssef

Posté à 10:18h, 03 juilletBonjour,

Merci pour ce tuto,

pour se qui non pas le fichier robots.txt :

comment le crée

ou

comment désindexé un dossier « sous domaine » .

Merci.

Anaïs Villelongue

Posté à 11:16h, 03 juilletBonjour Youssef,

Pour désindexer un sous domaine, vous devez y écrire dessus :

User-agent: *

Disallow: /

Puis vous devez placer ce fichier dans votre serveur FTP, en racine du sous-domaine concerné (en cliquant sur le dossier du sous domaine, vous arrivez « à la racine » du dossier »).

Pour creer un fichier .txt, si vous n’avez pas de programme pour ça, vous pouvez partir d’un fichier .txt existant, en le téléchargeant n’importe quel fichier de votre serveur puis en le modifiant (c’est à dire en changeant le nom pour robots.txt et en modifiant son contenu).

Youssef

Posté à 12:34h, 03 juilletMerci pour votre réponse.

Si j’ai compris, je crée un fichier robots.txt dans la racine du site et je le remplis par :

User-Agent: *

Disallow: /repertoire/

Anaïs Villelongue

Posté à 13:54h, 03 juilletNon, seulement :

User-agent: *

Disallow: /

tel quel ! ;)

David Barros

Posté à 11:45h, 25 juillet.Bonjour et merci pour toutes ces informations!

Je travail avec l’éditeur WIX qui ne me permet malheureusement pas de modifier le fichier Robots.txt.

Je souhaite cependant supprimer des vieux URLS indexés pas Google, qui sont actuellement en redirection 301.

1.J’ai redirigé tous les liens des pages 404 vers la page d’accueil. ( Cela est une fonction WIX )

2.J’ai supprimer plus de 200 liens avec l’outil de suppression d’urls proposé par la Search Console.( Etat indiqué Supprimée)

3.J’ai soumis un mon sitemap.xml à l’aide de la Search Console.

Pendent un temps un certains nombre d’urls ne s’affichaient plus mais ont fini par réapparaître!

Je suis désemparé car cela fait 2 semaines que je me tire les cheveux dans le but d’améliorer mon référencement et les choses sont de pire en pire.

Petite remarque certainement important, dans la Search Console je suis propriétaire de 2 versions de mon site en « http » et « https ».

Dois-je travailler uniquement sur la version « https » pour éviter des confusions entre l’ancienne et nouvelle version du site?

Je suis un peu perdu donc vos conseils d’expert me permettrons peut-être d’y voir un peu plus clairement.

Merci d’avance pour votre aide.

David

Anaïs Villelongue

Posté à 13:02h, 25 juilletBonjour David,

Merci pour votre message !

Vous devez tout d’abord si ce n’est pas le cas définir un site favori (celui en https de préférence) :

Sur la page d’accueil de la Search Console, cliquez sur le site de votre choix.

Cliquez sur l’icône en forme de roue dentée , puis sur Paramètres du site.

Dans la section Domaine favori, sélectionnez l’option de votre choix.

Ensuite, l’outil de suppression d’URL ne permet d’effectuer qu’une suppression temporaire ! Pour supprimer définitivement vos pages, ne faites pas de redirection, au contraire assurez vous que votre serveur affiche bien une page 404 pour ces vieilles urls et petite astuce: Bloquez l’accès au contenu, en ayant recours à la saisie obligatoire d’un mot de passe, par exemple (en haut à droite de votre page wordpress vous avez cette option dans VISIBILITÉ : au lieu de « public », mettez « protégé par mot de passe »). Google finira normalement par ne plus les indexer… ;)

Tenez moi au courant !

David Barros

Posté à 14:29h, 27 juilletBonjour Anaïs, merci pour vos réponses très utiles.

En suivant vos conseils j’ai défini mon site favoris en «www.nomdedomaine.com» et nom en «nomdedomaine.com».

Cela dit il n’est pas possible de préciser que le favoris est «https» et non «http».

Du coup je me retrouve à gérer 4 propriétés pour un même site!

http://www.nomdedomaine.com

https://www.nomdedomaine.com

http://nomdedomaine.com

https://nomdedomaine.com

Parmi ces 4 propriétés ou dois-je publier mon sitemap.xml?

Faut-il travailler sur les 4 propriétés?

J’ai également suivis votre 2ème conseil en suppriment toutes les redirections et j’attends maintenant que Google désindexe toutes les pages 404.

Le fait que Google trouve plus de 200 pages 404, cela peut-il nuire au positionnement de mon site dans les résultats de recherches?

Si oui, quoi faire pour regagner la confiance de Google?

Merci d’avance pour votre aide.

Très Cordialement

David

Anaïs Villelongue

Posté à 14:49h, 27 juilletBonjour,

Oui vous avez 4 propriétés mais ne travaillez que sur votre domaine favori.

Pour ce qui est des erreurs 404, avez vous fait avant une demande de suppression pour toutes ces urls ?

David Barros

Posté à 15:43h, 27 juilletDésolé d’ouvrir un nouveau message à chaque fois, mais je ne parvient pas à vous répondre sur le message initial.

Quand je clic sur le bouton répondre rien ne se passe!

Pour revenir au sujet de base, j’imagine que mon domaine favoris sur le quel je doit travailler est https://www.composant-dynamique.com ?

En effet dans Indexe Google > URL à supprimer, j’ai demander à masquer temporairement 263 URLS qui sont actuellement en statut supprimée.

Quand je saisi site:www.composant-dynamique.com dans le moteur de recherche, je vois que tout les liens sont toujours indexés par Google.

Étant donné que je travail avec WIX, je n’ai pas accès aux options de visibilités pour les anciennes URLS.

La seul chose que je peu faire est masquer une page des moteur de recherches si cette page existe encore dans l’éditeur.

Pour une même page il est possible d’avoir des 100 URLS donnant accès aux différentes images de cette page!

Est-ce normal ?

Voici un exemple:

https://www.composant-dynamique.com/home?lightbox=dataItem-jjzt8rne1

Je n’ai aucun contrôle sur ces URLS qui sont générés automatiquement par WIX.

95% des erreur 404 viennent d’anciennes URLS qui donnait accès à des images.

Suis-je suffisamment clair?

Merci.

David

Anaïs Villelongue

Posté à 16:30h, 27 juilletLes choses se compliquent apparemment… :) Je vous propose de me contacter en privé à avillelongue@beinwbe.fr

Merci !

fl0645

Posté à 13:55h, 29 juilletBonjour, j’ai que des erreurs dans le robots.txt d’après la search console, quelqu’un pourrait me dire ce qui ne va pas ? Merci d’avance !!

Sitemap: http://filmeur.net/sitemap.xml

Allow: /globalUser-agent: *

Disallow: /xmlrpc.php

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/

Allow: /wp-content/uploads/

Disallow: /wp-login.php/

Disallow: */trackback/

Disallow: /*/comments/

Disallow: /cgi-bin/

Disallow: /*.php$/

Disallow: /*.inc$/

Disallow: /*.gz/

Disallow: /*.cgi/

# URLs autorisées CSS JS Analytics pour les Bots

Allow: /*css?*/

Allow: /*js?*/

Allow: /*?utm*/

Allow: /css/?/

# Autoriser Google ImageUser-agent: Googlebot-Image

Allow: /*

# Autoriser Google AdSenseUser-agent: Mediapartners-Google*

Allow: /*

Disallow: /http://filmeur.net/reportage-photo-de-mariage-base-a-annecy-2349/

Noindex: /http://filmeur.net/reportage-photo-de-mariage-base-a-annecy-2349/

Disallow: /http://filmeur.net/portfolio-items/beauty__trashed/reportage-photo-de-mariage-base-a-annecy-2128-2/

Noindex : /http://filmeur.net/portfolio-items/beauty__trashed/reportage-photo-de-mariage-base-a-annecy-2128-2/

Disallow: /http://filmeur.net/contact_cameraman_photographe_mariage_74/cameraman-photographe-annecy-74-2/

Noindex: /http://filmeur.net/contact_cameraman_photographe_mariage_74/cameraman-photographe-annecy-74-2/

Disallow: /http://filmeur.net/creative-portfolio-3-2/

Noindex: /http://filmeur.net/creative-portfolio-3-2/

Disallow: /http://filmeur.net/a-propos-cameraman-photographe-annecy-suisse/desktop-with-photography-equipment-2/

Noindex: /http://filmeur.net/a-propos-cameraman-photographe-annecy-suisse/desktop-with-photography-equipment-2/

Disallow: /http://filmeur.net/portfolio8/

Noindex: /http://filmeur.net/portfolio8/

Disallow: /http://filmeur.net/newborns_featured/

Noindex: /http://filmeur.net/newborns_featured/

Disallow: /http://filmeur.net/portfolio-items/lifestyle/

Noindex: /http://filmeur.net/portfolio-items/lifestyle/

Disallow: /http://filmeur.net/reportage-photo-de-mariage-base-a-annecy-2349/

Noindex: /http://filmeur.net/reportage-photo-de-mariage-base-a-annecy-2349/

Disallow: /http://filmeur.net/portfolio-items/monochrome-blog/

Noindex: /http://filmeur.net/portfolio-items/monochrome-blog/

Disallow: /http://filmeur.net/a-propos-cameraman-photographe-annecy-suisse/desktop-with-photography-equipment/

Noindex: /http://filmeur.net/a-propos-cameraman-photographe-annecy-suisse/desktop-with-photography-equipment/

fl0645

Posté à 14:19h, 29 juilletah solutionné, il manquait : User-agent: *

Anaïs Villelongue

Posté à 23:47h, 29 juilletVoilà ! Parfait :)

Mack

Posté à 15:38h, 28 aoûtBonjour Anaïs! J’ai récemment fait une analyse de site sur Siteliner, et il s’avère que le contenu dupliqué sur mon blog est de 17%, soit 3% de plus que la moyenne. Alors qu’en réalité, ça n’est pas du tout représentatif de mes articles. La page d’accueil du site contient les derniers articles publiés, et pour chacun d’eux, un paragraphe représentatif. Ce qui donne à la page un taux de 89% pour le contenu dupliqué, et de facto hausse le taux global de C.D sur le site.

Ce que je voudrais, c’est de pouvoir supprimer ces « paragraphes » et de ne garder que le titre et l’illustration de chaque article. Sauf si vous me confirmez qu’il n’est pas dangereux de désindexer la page d’accueil, auquel cas je pourrai opter pour cette solution.

Anaïs Villelongue

Posté à 16:17h, 28 aoûtbonjour ! Non ne désindexez surtout pas votre page d’accueil, c’est une grave erreur de référencement ! Pour ce qui est du contenu dupliqué, il me semble que vous me parlez de contenu dupliqué interne à votre site, dans ce cas là, ce n’est pas très pénalisant pour votre référencement. Ne vous inquiétez pas :)

christian

Posté à 23:40h, 30 novembreBonjour j’aimerais ne plus indexer cette page sur les moteurs de recherche : https://befreetalent.fr/mentions-legales/

ma question est la suivante : pour désindexer une page via google je dois utiliser la search console + fichier robots.txt ?

Le lien de mon site : https://befreetalent.fr/mentions-legales/

Anaïs Villelongue

Posté à 23:43h, 30 novembreBonjour,

Vous pouvez utiliser soit l’un, soit l’autre !

Vincent

Posté à 12:30h, 03 novembreBonjour Anaïs,

Il semble que la dernière version de Yoast ne permette plus ce changement (sauf en Premium?)

Anaïs Villelongue

Posté à 13:26h, 03 novembreBonjour Vincent,

Non c’est toujours dans la section « Avancé » (dernière section du 1er onglet SEO) en bas de chaque page ! :)

Julie

Posté à 03:53h, 01 marsBonsoir, merci pour votre article bien détaillé, mais j’ai un problème ma page « wp-admin » de mon site. Voici le message de google search console: Indexée malgré le blocage par le fichier robots.txt

Je suis allée voir et j’ai bien:

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Pouvez-vous m’aider? Merci beaucoup

Anaïs Villelongue

Posté à 16:46h, 01 marsBonjour Julie,

Merci pour votre commentaire. Oui c’est bon ! Vous pouvez laisser Allow: /wp-admin/admin-ajax.php, cela permet à Google de voir comme votre site est construit et il aime ça :)

Funk

Posté à 12:33h, 09 septembreBonjour,

Je souhaite désindexer sur Google un sous-domaine sauf que ce dernier a été carrément supprimé du serveur et du DNS par l’ancien webmaster (suite à un hack).

Je ne vois pas comment mettre le robots.txt si le site n’existe plus, mais continue à être référencé par Google et Bing.

Merci

Anaïs

Posté à 13:38h, 09 septembreBonjour,

Vous pouvez vous rendre sur votre compte Search Console puis indiquer le sous-domaine à désindexer. Si votre sous-domaine a été supprimé, celui-si devrait de toute façons ne pas tarder à être déindexé !

Mm

Posté à 19:31h, 23 septembreBonjour

j’ai un problème au niveau de mon site

mes pages sont indexés correctement, mais google m’envoi des erreurs des pages introuvable, ces page la n’existe pas vraiment dans mon site.

je na sais pas comment dire à google que ces pages d’erreur n’existe pas ou comment les supprimer

merci de répondre

Anaïs

Posté à 20:40h, 23 septembreBonjour,

Vous devez passer par l’outil « Google Search Console ». Dans le menu « Index Google » puis dans l’onglet « urls à supprimer », vous pouvez demander à Google d’arrêter d’indexer une page en question !

https://search.google.com/search-console/about

Raphaël Web

Posté à 07:41h, 11 janvierBonjour,

Toutes mes images sont indexé sur google quand je fais site:mondomaine.com j’ai toutes les images mondomaine.com/service/imagexxxxx. Comment résoudre ce probleme ?

Anaïs

Posté à 12:01h, 11 janvierBonjour,

C’est à dire ? J’ai peur de ne pas avoir bien compris le problème…